L’intelligence artificielle (IA) est un logiciel qui apprend, grâce à beaucoup d’exemples, à reconnaître des ressemblances dans des images, des sons ou des textes pour aider à donner une réponse (trier des photos, proposer un chemin, résumer un petit texte…). Elle n’a pas de sentiments et ne “comprend” pas comme un humain : elle imite ce qu’on lui a appris. Bien utilisée, elle rend de vrais services ; mal utilisée, elle peut se tromper, être injuste ou trop curieuse avec nos informations. L’IA est un outil : les humains fixent les règles et gardent la décision finale.

Pourquoi dit-on « artificielle » ?

On dit artificielle parce que cette “intelligence” est fabriquée par des humains et fonctionne dans une machine. Elle n’apparaît pas toute seule dans la nature. Elle peut réussir des tâches impressionnantes (reconnaître un visage, traduire une phrase), mais elle n’a ni conscience, ni émotions, ni valeurs morales. Reste une question : que veut dire “intelligence” au juste ?

Qu’est-ce que « l’intelligence » ?

De façon simple : apprendre, comprendre une situation nouvelle et s’y adapter pour résoudre un problème. Chez l’humain, cela inclut la logique, le langage, la créativité, l’attention aux autres et des valeurs (justice, empathie). On parle parfois d’intelligences au pluriel pour rappeler qu’on peut être doué de différentes manières (logique, langage, arts, relation aux autres…).

D’où part-on pour créer une IA ?

On commence par une question utile et précise : “Peut-on retrouver automatiquement les photos de notre chien ?”, “Peut-on repérer plus vite une anomalie sur une image médicale ?”. Puis on fixe des règles claires : quelles informations a-t-on le droit d’utiliser (photos, textes, sons) ? Sont-elles autorisées et fiables ? On prépare une valise d’exemples variés (cas faciles, difficiles et “pièges”). On fait un premier essai pour voir si l’IA fait mieux que le hasard. On mesure, on corrige, on recommence. Quand ça tient la route, on élargit les exemples (autres lumières, autres accents, autres façons de parler) pour vérifier que l’IA reste utile même si le contexte change. Et des humains surveillent toujours le système pour arrêter ou corriger si nécessaire.

Les premières formes d’IA

Au tout début : les règles.

On disait à l’ordinateur : “Si ceci arrive, alors tu fais cela.” Ça marchait bien pour des situations très simples et prévues à l’avance. Mais dès que la vraie vie devenait un peu floue ou surprenante, l’ordinateur ne savait plus quoi faire.

Ensuite : les “experts dans la machine”.

Des spécialistes ont donné des milliers de règles à l’ordinateur. Il devenait fort dans un petit domaine (par exemple un type de diagnostic). Le problème ? C’était lourd à mettre à jour et ça cassait si la situation changeait un peu.

Puis : apprendre avec des exemples.

Au lieu d’écrire des règles sans fin, on a montré à l’ordinateur beaucoup d’images, de sons et de textes. Il a appris à repérer des ressemblances et à se débrouiller dans des cas proches de ce qu’il connaissait déjà.

Aujourd’hui : apprendre à très grande échelle.

Avec énormément d’exemples et des ordinateurs puissants, certaines IA sont très performantes. Mais elles ont toujours besoin de limites claires, de données justes et d’un contrôle humain pour rester utiles et équitables.

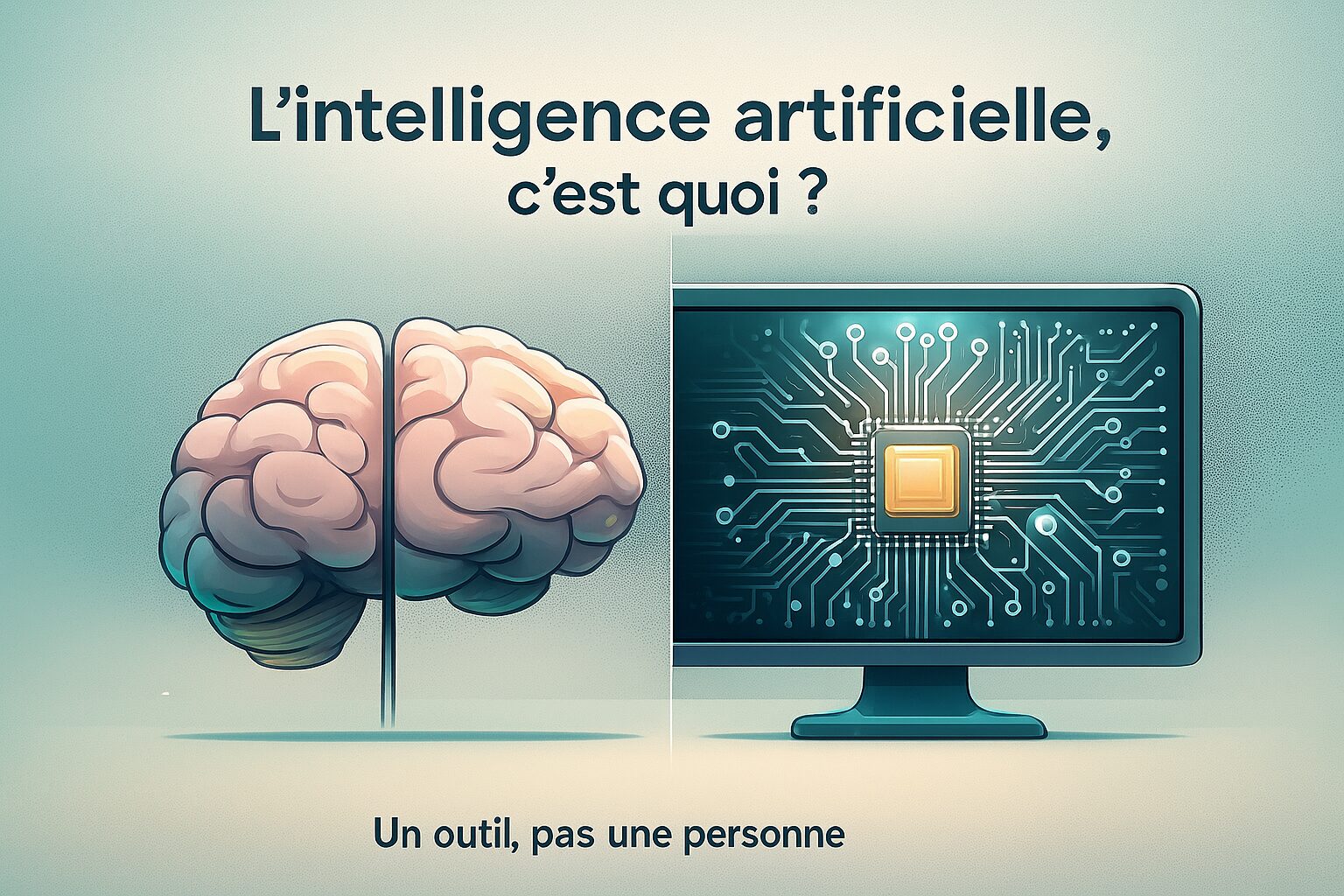

Comment ça marche

- On choisit un but clair (ex. “reconnaître tel objet”).

- On réunit des exemples autorisés (images, textes, sons).

- Le programme s’entraîne : il essaye, on lui montre où il se trompe, il corrige et réessaye des milliers de fois.

- Quand il est prêt, il propose des réponses très vite.

- On surveille : il peut se tromper ou même inventer une réponse qui a l’air vraie.

Pour que cette chaîne soit utile et sûre, il faut des équipes et un but réel : voyons qui fait quoi, et pourquoi.

Qui crée l’IA et pourquoi ?

Des équipes mélangées : techniciens, chercheurs, personnes qui préparent et vérifient les exemples, designers, juristes, spécialistes de l’éthique. Pourquoi ? Pour aider dans des tâches longues et répétitives, repérer des signaux difficiles à voir, et suggérer des réponses que des humains valident. L’objectif n’est pas de remplacer le jugement humain, surtout quand l’erreur serait grave.

Exemples concrets

Trier les photos du téléphone.

Tu tapes “chat” et toutes les photos avec un chat apparaissent. L’IA a appris, en voyant des milliers d’images, à reconnaître des ressemblances (oreilles pointues, museau, moustaches) même si la lumière change. Elle ne “sait” pas ce qu’est un chat comme toi, mais elle repère le motif et te fait gagner du temps.

Le clavier qui devine le prochain mot.

Quand tu écris, le clavier propose le mot suivant. L’IA a remarqué que certains mots vont souvent ensemble (“bon” → “jour”). C’est pratique, mais il faut relire : la machine n’a pas ton intention.

Trouver le meilleur chemin sur une carte.

L’IA compare des routes, des vitesses, l’heure, parfois la météo. Elle propose un trajet rapide ou plus sûr selon ton choix. Elle suggère un plan ; toi, tu décides.

Sous-titres automatiques pour une vidéo.

L’IA transforme les sons en mots. Très utile, mais moins bon avec le bruit ou des accents forts. Elle aide, et tu gardes l’œil.

Filtrer les messages indésirables (spam).

Le courrier classe les spams tout seul en repérant des signaux qui reviennent (liens étranges, promesses trop belles). Ça protège, mais il faut vérifier parfois le dossier “indésirables”.

Recommandations de musique ou de vidéos.

Après une chanson que tu aimes, l’appli en propose d’autres “du même style”. C’est agréable pour découvrir, mais pense aussi à explorer par toi-même pour ne pas tourner en rond.

Vie privée : que partage-t-on ?

Beaucoup d’applications demandent des données (photos, localisation, contacts). On peut limiter ce partage : régler la confidentialité, refuser ce qui n’est pas nécessaire, poser la question « pourquoi en as-tu besoin ? ».

Justice et biais

Une IA peut être injuste si elle a surtout vu des exemples d’un seul type (visages, accents, formes de texte…). Pour éviter ça, on teste sur des publics variés, on corrige et on surveille. Les humains restent responsables.

Erreurs “qui ont l’air vraies”

Parfois, l’IA hallucine : elle invente une info crédible mais fausse. Réflexe : vérifier avec deux sources fiables, surtout si la réponse est surprenante ou trop parfaite.

Deepfakes : repérer le faux

Des images/vidéos peuvent être fabriquées. Indices simples : ombres incohérentes, clignements bizarres, mains/objets “fondus”, voix étrange, source inconnue. Bon réflexe : remonter à l’origine et chercher une version officielle.

Quand ne pas utiliser l’IA

Pour des décisions sensibles (santé, sécurité), des sujets très personnels, ou des devoirs à faire en autonomie. L’IA aide, mais elle ne remplace pas l’apprentissage ni le jugement humain.

Qui décide des règles ?

Il existe des lois et des chartes qui encadrent l’IA (vie privée, sécurité, transparence). Les écoles, familles et services fixent aussi leurs propres règles d’usage : ce qui est permis, ce qui ne l’est pas, et qui vérifie.

Écologie et coûts

Entraîner et faire tourner certaines IA consomme de l’énergie. Idée simple : privilégier les usages utiles, fermer ce qu’on n’utilise pas, éviter les requêtes “gadgets”.

L’IA n’est pas une personne

Pas d’émotions, pas de conscience, pas de valeurs. L’IA imite des réponses apprises ; l’humain reste responsable.

Bienfaits, risques : est-ce une bonne chose ?

Bienfaits : aides pour les personnes en difficulté (lecture, vision, audition), soutien aux soignants et enseignants, sécurité (alertes plus tôt), moins de temps perdu sur les tâches répétitives, coup de pouce à la créativité. Risques : erreurs qui semblent vraies, injustices si les exemples sont mauvais, vie privée menacée si l’on collecte trop d’infos, dépendance (laisser la machine décider), désinformation, coût énergétique, métiers qui changent. Conclusion : l’IA n’est ni “bonne” ni “mauvaise” ; tout dépend de nos choix et de nos règles. Un humain doit garder la main.

Six repères simples pour un usage responsable

- C’est une machine : elle peut se tromper.

- Protéger les infos : partager le minimum nécessaire.

- Vérifier : croiser avec au moins deux sources fiables.

- Demander l’origine des informations : si ce n’est pas clair, prendre du recul.

- Garder la décision humaine pour les sujets importants.

- Utiliser l’IA pour comprendre, pas pour tricher.

Mini-quiz

- L’IA a-t-elle des émotions ? → Non.

- Pourquoi faut-il des exemples variés et justes ? → Pour éviter erreurs et injustices.

- Qui garde la décision finale sur ce qui compte ? → Les humains.

Petit lexique

Données : Images, textes ou sons que l’on montre au programme pour apprendre.

S’entraîner :Essayer, corriger, réessayer, jusqu’à faire mieux.

Hallucination :Réponse inventée qui a l’air vraie.

Biais : Injustice copiée depuis de mauvais exemples.

Assistant IA : Programme qui aide sans remplacer le jugement humain.